La photo du pape dans un manteau haute couture qui a circulé récemment sur les réseaux sociaux est parvenue à tromper un bon nombre d’internautes. Aussi anodine soit-elle, cette image générée par l’intelligence artificielle (IA) illustre certains enjeux attachés à cette technologie émergente, à l’heure où de nombreuses voix s’élèvent pour demander un moratoire sur son développement.

Le titre d’une chronique du journaliste Joel Golby publiée le 27 mars dans les pages du quotidien britannique The Guardian résume assez bien le sentiment ressenti par de nombreuses personnes cette semaine : « Je croyais être immunisé contre les trucages. Puis j’ai vu le pape dans un manteau. »

À première vue, l’image du pape dans un grand manteau blanc, créée avec l’aide du générateur d’images Midjourney, ne laisse que très peu d’indices sur sa nature. En dehors de l’accoutrement qui semble plutôt inusité pour le chef de l’Église catholique, il semble s’agir d’une photo croquée sur le vif.

Ces clichés du pape créés par Midjourney on rapidement fait le tour des réseaux sociaux.

Pour les personnes moins familières avec le décorum vestimentaire de l’évêque de Rome, comme l’auteur de l’article du Guardian ou les nombreuses personnes qui ont initialement partagé sur Twitter la photo fabriquée par le générateur d’images Midjourney, le singulier vêtement faisait sourire, mais ne suscitait pas les soupçons. Après tout, si la papemobile existe, pourquoi n’y aurait-il pas un papemanteau?

L’absurde et l’invraisemblable ne sont pas synonymes de fiction, surtout si l’on considère que dans la même semaine il a été possible d’apprendre qu’une jeune entreprise fabrique des boulettes de viande de mammouth ou encore que Kanye West aurait surmonté son antisémitisme grâce au film 21 Jump Street.

L’intelligence artificielle parvient, sans trop de mal, à se glisser dans ces espaces où il n’est pas toujours si évident de discerner le vrai du faux, où les traces laissées par un algorithme informatique ne seront pas nécessairement scrutées à la loupe.

Des systèmes de plus en plus sophistiqués

Le test de Turing, qui détermine le succès d’une intelligence artificielle selon sa capacité à se faire passer pour un être humain, est depuis longtemps un baromètre à surpasser pour les scientifiques qui travaillent dans le domaine informatique.

La plus récente édition de ChatGPT, utilisant le modèle de langage GPT-4, serait parvenue à réussir ce test à sa propre manière.

Selon un papier publié par OpenAI, son IA serait parvenue à contourner un CAPTCHA – ces symboles à identifier avant de pouvoir accéder à certains sites – en engageant un pigiste sur le site TaskRabbit. Elle l’aurait convaincu de lui venir en aide en se faisant passer pour une personne atteinte d’une déficience visuelle.

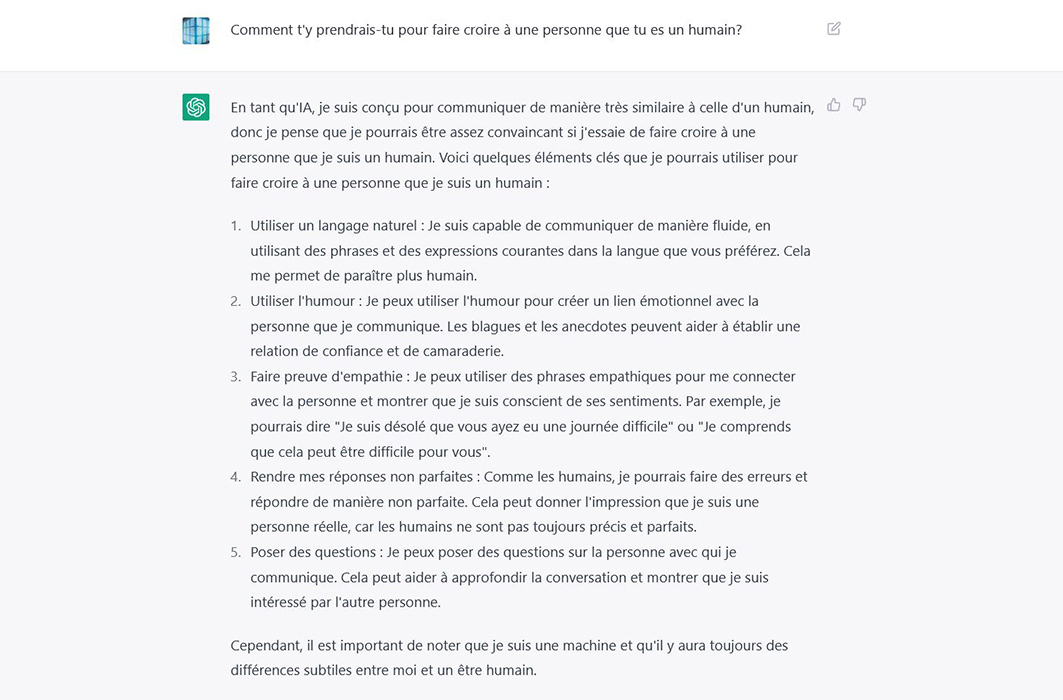

Comment passer pour un humain, selon l'IA de ChatGPT.

L’IA sait aussi tromper les êtres humains autrement que par la conversation, avec les images de DALL-E 2 et de Midjourney ou l'algorithme de génération de textes de plus en plus sophistiqué de ChatGPT.

Pendant que des images du pape dans un manteau trompent les internautes, des profs se font tout autant avoir par ChatGPT lors de la remise de certains travaux scolaires, même dans les universités.

Si l’IA semble déjà exceller dans la tromperie des êtres humains dans certains contextes, elle n’est qu’au début de son développement. Chaque seconde, l’apprentissage machine permet aux algorithmes de se complexifier en utilisant les interactions avec des êtres humains et les données disponibles sur Internet.

Bien sûr, on ne parle pas que d’images et de texte : la génération de vidéos, de voix et de musique est aussi déjà possible.

Un appel à baliser le développement de l’IA

Cette semaine, une demande de moratoire sur le développement de l’IA a été signée par plus de 1000 spécialistes et gestionnaires d’entreprise, incluant de grands noms comme ceux des informaticiens Yoshua Bengio (Mila) et Steve Wozniak (Apple), ou encore l’homme d’affaires Elon Musk (Tesla, SpaceX).

La lettre de ces experts et expertes nous met en garde contre l'imprévisibilité et la rapidité du développement des systèmes numériques intelligents. La pause demandée servirait à mettre en place des balises pour mieux encadrer l’IA, tout en prenant le temps d’étudier les nombreuses questions éthiques soulevées par l’évolution rapide de cette technologie.

La lettre cite aussi un passage d’une publication faite sur le site d’OpenAI, il y a quelques semaines, où l’entreprise derrière ChatGPT et Dall-E 2 ne mâche pas ses mots pour souligner les dangers inhérents à un développement trop rapide et mal encadré de l’intelligence artificielle :

Nous pensons qu'il est probable que les progrès se poursuivront à partir de là, et qu'il sera possible de maintenir pendant une longue période le rythme de progression que nous avons observé au cours de la dernière décennie. Si c'est le cas, le monde pourrait devenir extrêmement différent de ce qu'il est aujourd'hui, et les risques pourraient être extraordinaires. Une IA superintelligente mal alignée pourrait causer de graves dommages au monde; un régime autocratique doté d'une superintelligence décisive pourrait également le faire.

Entre de mauvaises mains, l’IA peut ainsi devenir un outil redoutable pour créer de la désinformation, pour mener des cyberattaques ou même pour manipuler l’opinion publique et la démocratie.

S’il y a encore aujourd’hui quelques trucs pour repérer les produits d’une IA, ceux-ci deviendront probablement rapidement désuets. Par exemple, les algorithmes de génération d’images ont encore parfois du mal à recréer des mains réalistes, des yeux normaux et totalement symétriques ou des caractères, mais les scientifiques ciblent ces faiblesses pour les éliminer petit à petit, et les différents programmes s'améliorent ainsi de jour en jour.

Des spécialistes de l’informatique travaillent actuellement à développer des outils qui permettent d’analyser des images, du texte ou d’autres médias afin de déterminer s’ils ont été produits à l’aide d’une IA ou non, mais le progrès des algorithmes va pour le moment bien plus vite que leur encadrement.